Marie-France Bazzo écrivait ce matin : «J'assume et je réitère: De + en+, on vote avec légèreté et incompétence citoyenne. À ts les paliers de gouvernance. #VoteFB»

Le vote de lundi soir en a laissé plus d'un avec un mal de crâne pour expliquer ce qui s'était passé. Faut-il réformer les élections?

À la blague, sur le

blogue Triplex de Radio-Canada je proposais mardi des solutions 2.0 pour moderniser les élections dans une démocratie accro aux réseaux sociaux.

- Mettre des « J’aime » à côté du nom des candidats,

- Permettre de retweeter son choix,

- Distribuer les sièges au Parlement en fonction du nombre de membres des pages Facebook des partis.

- Et pourquoi pas? Permettre d’adhérer à plus d’un groupe.

1 vote vaut 1000 like

Pour horripiler les bien-pensants et conforter les dénigreurs des médias sociaux, imaginons ce que Élection Canada pourrait faire pour attirer les électeurs à s'intéresser à la politique à l'ère du 2.0.

Le vote secret? Tellement 2 mai 2011. Non, on rend tout public, c'est tellement plus in:

Pour amener les électeurs sur le lieu de vote, tous les moyens sont bons:

Ou alors on vote dans le confort de Facebook et on connait instantanément les résultats:

Une fois au pouvoir, il y a bien des widgets qui permettraient de créer une démocratie participative.

Google Shared Spaces offre un bon point de départ:

Jeu sérieux

Oui, la politique est un jeu sérieux et les médias sociaux ressemblent plus à une foire où règnent la franche camaraderie et parfois la fange immonde. C'est la même différence entre un entraîneur sportif et un gérant d'estrade.

On parle, on s'agite et on dit tout haut ce qu'on pense. Espérant secrètement que les autres vont mettre nos idées en action.

Oui, le web a donné à tous la possibilité d'exercer une forme de pouvoir (un «cinquième pouvoir»?), mais un pouvoir qui confronte davantage et joue sur le terrain des médias (ce « quatrième pouvoir »).

Le Web 2.0 a-t-il changé la politique ? Indirectement. Il a changé les médias, qui eux ont un pouvoir sur la politique. Mais il l'a en même temps fragmenté les médias, qui se trouvent affaiblis face aux politiques.

Et il n'y a que les élitistes qui se drapent dans la bonne conscience pour refuser la démocratisation des médias comme une bonne chose. Internet a tout au plus brassé la cage, changé la donne, redistribué les cartes.

Et pendant un temps, on va vivre ce que procure le web 2.0, un sentiment de pouvoir. Mais illusoire. Car oui, Facebook nous a habitués avec ces « j'aime...», le sentiment d'être en élection perpétuelle et que nos «votes« seraient pris en compte.

Les marchants en prennent compte. Mais pas en politique. En politique, ce sont ceux qui se battent qui dirigent.

Il n'y a pas une page Facebook, qu'importe le nombre d'abonnés, qui va influencer un projet de loi, un comité, une assemblée. La décision appartient à ceux qui s'impliquent, pas à ceux qui s'abonnent.

Converse toujours, tu m'intéresses

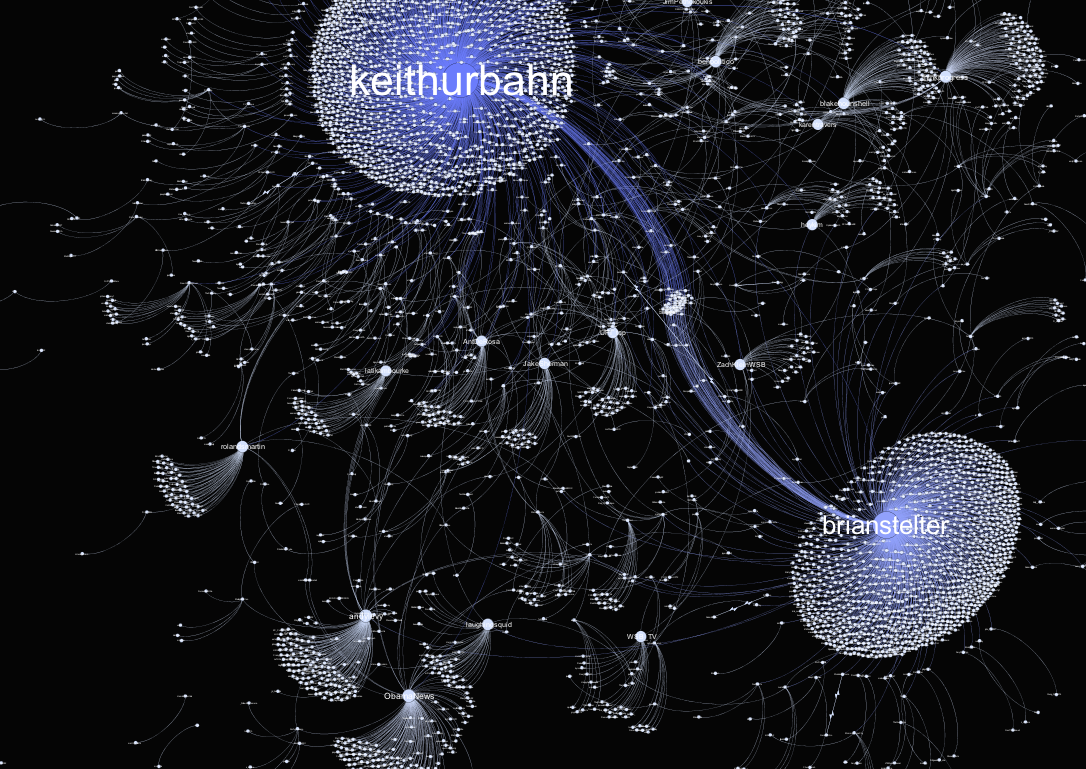

L'influence 2.0 se vérifie toutefois au niveau des opinions. Ou plutôt de la circulation des opinions. D'opinions moins mainstream. C'est l'endroit pour émettre librement une opinion et voir si du monde mord à l'hameçon.

C'est parfait pour consolider ses appuis et préparer ses arguments. Mais ça reste des paroles. Pas des actes. Dans ce sens, le «cinquième pouvoir » et le «quatrième » ne font qu'un. On agite des drapeaux, on signale, on informe.

La médiatisation en continu de la rumeur publique offre un instantané des réactions du peuple pour des institutions aux rythmes sommes toutes plus lents. Mais elle ne garantit pas son intégration dans le processus décisionnel.

Car l'action doit venir des gestes concrets: s'impliquer dans des comités, défendre, envers et contre tous, son idée, la peaufiner et la solidifier. Convaincre à chaque échelon. Et se battre encore même quand tout est gagné.

Alternatives électorales

La consternation face aux résultats de lundi dernier se résume bien dans ce qu'exprime Marie-France Bazzo: le peuple voterait à la légère. Soit. Peut-être qu'il y a matière à réflexion. Des pistes alternatives pour modifier le processus électoral existent...

La démocratie directe: avec l'arrivée d'internet, c'est probablement plus que jamais techniquement possible. Qu'elle soit souhaitable est une autre paire de manche. (lire

Les enjeux de la démocratie électronique, Hermès 2000.)

La sortition: c'est un procédé où les représentants sont tirés au hasard. Quand on y pense sérieusement, comme on a pu le voir lundi, les résultats ont été aussi aléatoires. (

plus de détails).

Modes de scrutin: on pourrait aussi changer de mode de scrutin : de scrutin majoritaire uninominal à un tour à celui à deux tours, ou à la proportionnelle, ou mixte. Chacun a ses avantages et ses inconvénients. (lire

Les différents modes de scrutin et leurs effets). Dans un pays de patchwork, ce n'est pas un changement évident...

Je reste convaincu que la désaffection des urnes (40% des Canadiens en droit de voter n'ont pas exercé leur droit) reste le plus grave problème. S'il y a un réel problème, il est là.

Et si avec les médias sociaux, la population a commencé à participer, c'est au final une bonne nouvelle. L'intention est là...

Je développe en ce moment une conférence pour l'EBSI dans le cadre de leur université d'été sur l'architecture de l'information.

Je développe en ce moment une conférence pour l'EBSI dans le cadre de leur université d'été sur l'architecture de l'information.